L'éditeur Microsoft et le constructeur de puces Nvidia viennent d'annoncer un nouveau modèle de langue naturelle, le Megatron-Turing Natural Language Generation (MT-NLG). Celui-ci appartient à la famille des réseaux neuronaux attentionnels de type "transformer", qui a fait beaucoup bouger le monde de l'IA du langage depuis 5 ans – certaines tâches de Youmean utilisent cette génération émergente des transformers.

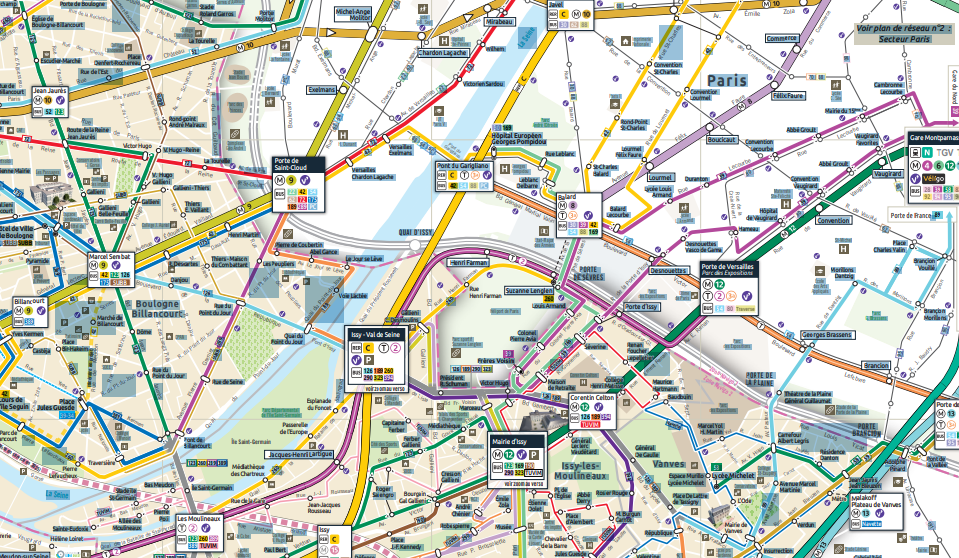

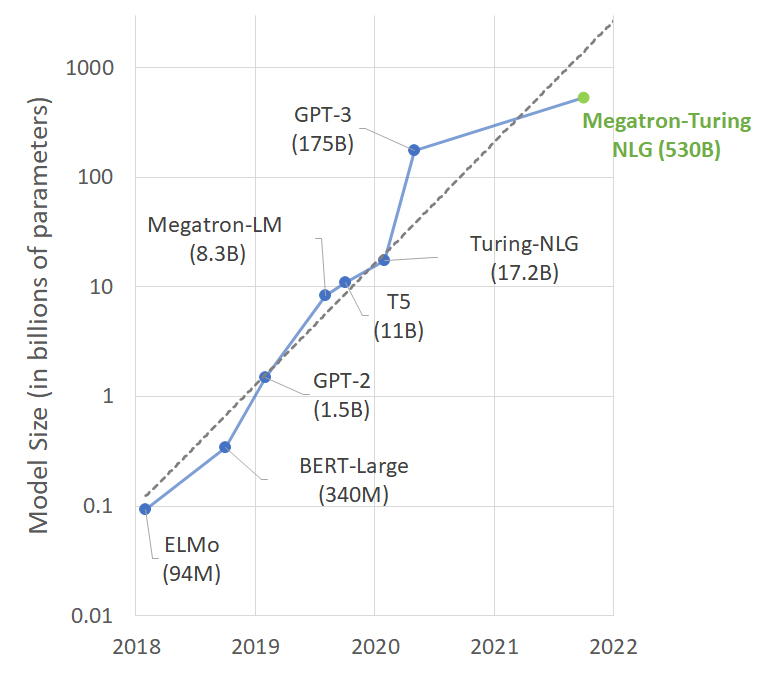

Le nouveau bébé de Microsoft et Nvidia atteint 530 milliards de paramètres pour décrire la langue, soit un nouveau bond en avant dans la course aux dimensions de l'IA du langage. Comme le montre cette image, la croissance de la taille des modèles (nombre de paramètres) est devenue exponentielle en quelques années.

Sur une tâche commune en test (finir une phrase à mot manquant), MT-NLG obtient un score de 87,2% de réussite, là où le précédent détenteur du record GPT-3 atteignait 86,4%.

Le gain est réel quoique d'apparence modeste pour le non-initié. Le hic, c'est le coût et la puissance requise.

Le Megatron-Turing NLG a demandé un mois d'entraînement sur 560 serveurs DGX A100, en réseau avec HDR InfiniBand dans une configuration d'arbre complet. Chaque DGX A100 dispose de huit GPU NVIDIA A100 80 Go Tensor Core. Au total 4480 cartes graphiques à GPU superpuissant... sachant que chacune d'elles coûte des milliers d'euros à l'achat dans le commerce. Le simple fait de faire tourner le modèle sur une requête demande 40 de ces GPUs, et 1 à 2 secondes pour accomplir la tâche.

Les chercheurs en IA sont très intéressés de savoir si cette course à la "force brute" continuera d'entraîner des gains, jusqu'à atteindre un niveau de maîtrise formelle de la langue comparable à celle d'un humain (très très) informé et cultivé. Certains pensent que oui, d'autres jugent qu'il faut plutôt améliorer les données d'entraînement et les algorithmes.

Quoiqu'il en soit, le gigantisme pose la question des applications commerciales et des capacités d'appropriation de l'IA par les publics qui en ont besoin. Non seulement l'entraînement d'un modèle de ce type coûte des millions de dollars, mais chaque tâche applicative exige une forte quantité de calcul pour tirer pleinement profit des capacités issues du grand nombre de paramètres. Ce sujet devient aussi sociétal, car l'IA consomme beaucoup d'énergie dans un monde où celle-ci pose des questions de soutenabilité face au changement climatique et à la raréfaction de certaines ressources.

Saluons donc la prouesse de la recherche la plus avancée en IA du langage. Mais veillons aussi à donner accès à des outils plus simples, plus opérationnels... et nettement plus abordables !