En 2012 se tient le ImageNet Large Scale Visual Recognition Challenge (compétition ImageNet de reconnaissance visuelle à drande échelle) . Ce concours est organisé par la base ImageNet qui contient des millions d'images annotées sur leur contenu. Il a pour objectif de tester les performances de solutions logicielles pour classer automatiquement des images.

Le précédent record, détenu par un modèle parallélisé de type SVM (classifieur linéiare), est de 71,8% de réussite dans les 5 meilleures classes. En 2012, le modèle AlexNet arrive à un score de 84,7% et il laisse le second loin derrière, avec plus de 10% d'avance. Le petit monde des experts en modèles d'apprentissage automatique est ébahi par la performance. Et se penche sur son secret : un modèle fondé sur les réseaux neuronaux convolutifs. L'article associé à la performance, signé par Alex Krizhevsky, Ilya Sutskever et Geoffrey Hinton devient l'un des plus cités de la recherche informatique.

Le deep learning, ou apprentissage profond, est né. Il va coloniser en une décennie la reconnaissance vocale, la vision par ordinateur, la conception de médicaments, la bio-informatique, l'imagerie médicale et le traitement du langage naturel. La solution Youmean utilise ainsi certains de ces modèles en langage.

La résurrection d'une idée ancienne

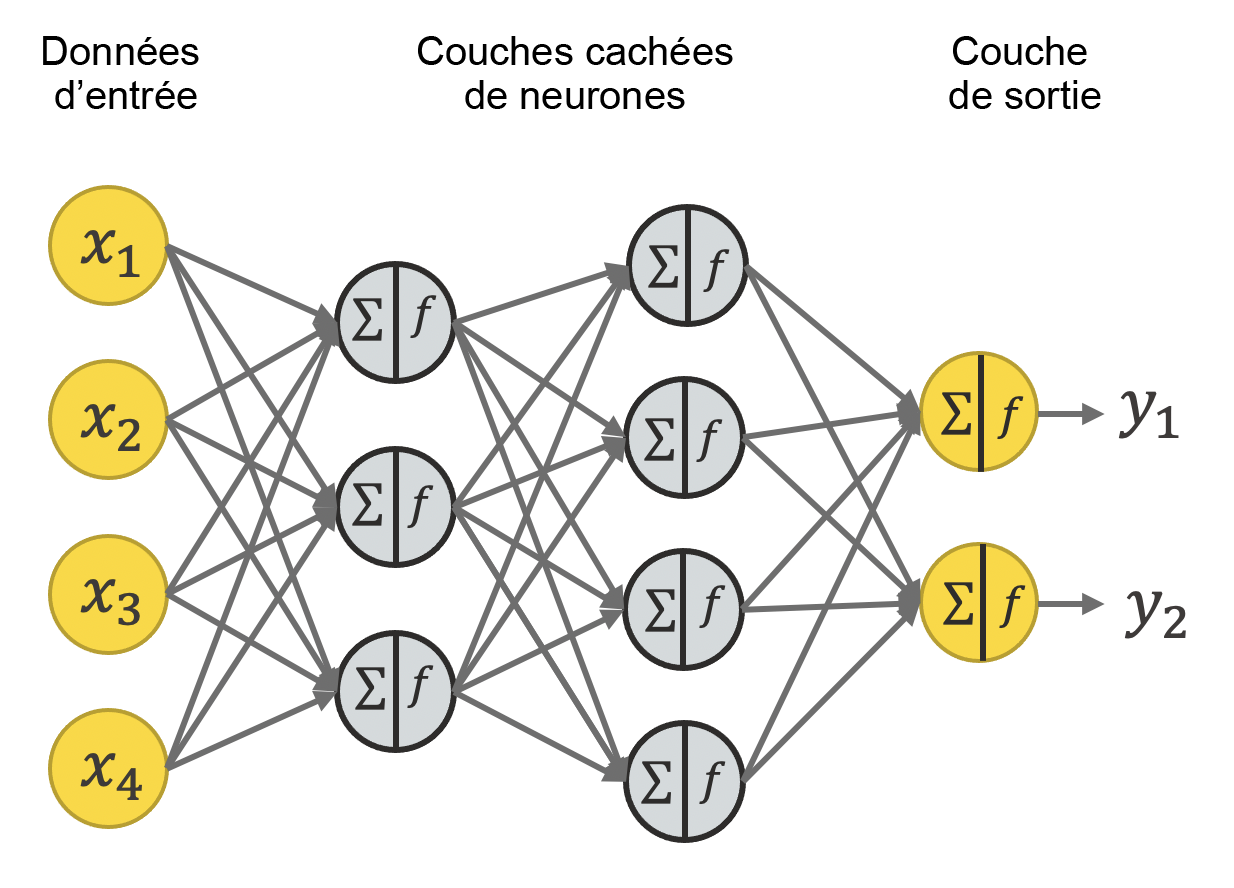

Cette naissance est en réalité une résurrection. Car la modélisation du traitement intelligent des données par des neurones formels est déjà une idée ancienne. En 1943, Warren McCulloch et Walter Pitts créent le principe du neurone formel, une représentation mathématique très simplifiée de la manière dont une unité du système nerveux (neurone) traite l'information de l'entrée (les données) vers la sortie (la décision, l'action). En 1957, Frank Rosenblatt met au point le perceptron, un modèle composé d’une couche de neurones en entrée et d’une couche en sortie, premier système capable d’apprendre par expérience à reconnaître des formes – et donc premier réseau de neurones artificiels.

Ces réseaux sont constitués d'unités connectées de neurones artificiels, chaque connexion transmet des signaux d'un neurone à un autre, l'apprentissage se fait en modifiant les poids des connexions entre les neurones. Au fur et à mesure que les réseaux augmentent en profondeur, les multiples couches peuvent progressivement extraire des caractéristiques de haut niveau à partir d'entrées brutes, ce qu'on appelle l'apprentissage profond (deep learning). Le mot "profond" fait référence à la profondeur des couches elle-même corrélée à la profondeur des paramètres de représentation de l'objet étudié.

Cependant, à la fin des années 1960, la mise en lumière des limites théoriques des modèles à une seule couche va doucher les enthousiasmes. Et si quelques fervents défenseurs des modèles dits "perceptron multicouches" maintiennent le flambeau des années 1970 aux années 2000, ils sont confrontés à des lenteurs de calcul qui rendent peu opérationnels leur architecture et les algorithmes associés.

Modèles plus intelligents, calculs plus puissants

Pourquoi AlexNet a changé les choses? Parce que des chercheurs, notamment rassemblés derrière Yann Le Cun, avaient continué à améliorer les architectures des réseaux neuronaux. AlexNet s’est largement inspiré de LeNet, mis au point 15 ans plus tôt. Et en raison de diverses innovations qui ont convergé dans la conception d’AlexNet : augmentation des couches de convolution (découpage de l’image pour extraire ses caractéristiques), ajout d’une couche de pooling (sélection des caractéristiques ayant du poids pour simplifier le calcul et éviter le surapprentissage), choix des fonctions finales de décision (ReLU), mobilisation des processeurs GPU (unités graphiques) car ils accélèrent énormément le calcul…

Dès l'année suivant la victoire d'AlexNet, Yann Le Cun est chargé par Mark Zuckerberg de créer le Facebook Artificial Intelligence Research (FAIR), organisme regroupant des laboratoires de recherche spécialisés dans l’IA, et en devient le directeur. Le chercheur français obtiendra le prix Turing (2019), équivalent Nobel de l'informatique, et il a raconté ces décennies décisives dans un ouvrage passionnant (Quand la machine apprend, La révolution des neurones artificiels et de l'apprentissage profond, 2019)

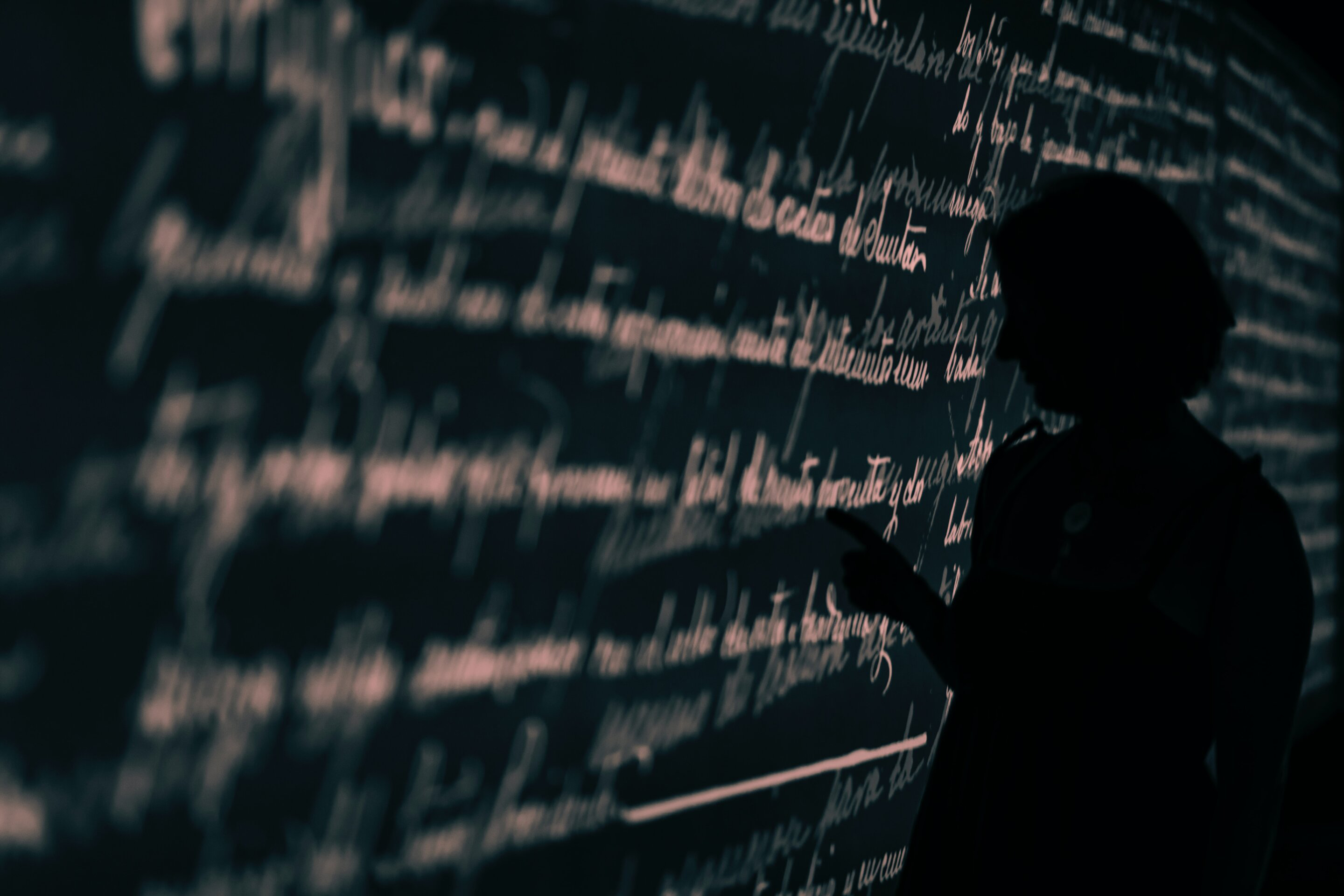

L'histoire de l'apprentissage profond continue de s'écrire. Car d'autres enjeux sont apparus, comme par exemple le problème de la "boite noire", c'est-à-dire l'opacité des décisions de l'IA dans ses neurones, ce qui nuit à leur interprétabilité et à leur amélioration. L'IA est très loin d'être une intelligence omnisciente dont certains survendent les capacités – en fait son intelligence reste très limitée, comme le rappelle avec modestie Yann Le Cun. Mais les prouesses qu'elle réalise déjà, le temps qu'elle fait gagner, les possibilités qu'elle ouvre dans l'assimilation des données massives de nos capteurs et interfaces numériques, les usages croissants par la recherche scientifique et technologique justifient amplement les espoirs que l'on place dans son évolution future.