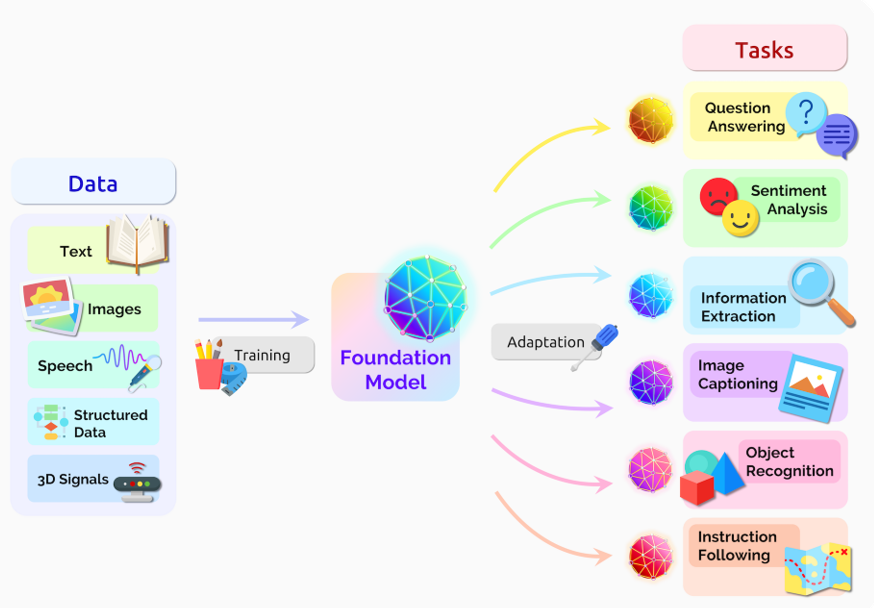

Dans un long article de synthèse, des chercheurs et ingénieurs de l’université Stanford prennent acte d’une évolution majeure dans les IA du langage à travers la naissance de ce qu’ils appellent des « foundation models » ou modèles de fondation (Bommasani et al 2021).

Le terme « modèle de fondation » désigne un changement de paradigme. Il existe d’autres appellations qui couvrent certains aspects techniques ou opérationnels : on parle de modèle « pré-entraîné », modèle « auto-supervisé », modèle « à usage général » (multipurpose), modèle « polyvalent », modèle « indépendant des tâches »... un modèle de fondation est tout cela à la fois, en raison de son orientation et architecture de conception. Et un peu plus que cela, car il fait émerger des capacités nettement supérieures pour comprendre le sens d’un texte ou répondre à une demande en langage naturel.

De quoi s’agit-il ? L’intelligence artificielle appliquée au langage existe depuis une soixante d’années. Mais elle a connu une mutation radicale à la fin des années 2010, avec une nouvelle architecture d’apprentissage profond appelée les « Transformers ». C’est la division IA de Google qui a mené la danse avec un papier de 2017, « Attention is all you need » (Vaswani 2017), proposant une nouvelle architecture des neurones artificiels en vue d’interpréter le sens des textes avec une vue bien plus large du contexte des mots.

Apprentissage par transfert et montée en échelle

Sur le plan technique, les modèles de fondation sont nourris en apprentissage par transfert (transfer learning). L'idée de l'apprentissage par transfert est de prendre les « connaissances » (fonctions de décision) apprises par le modèle sur une tâche et de les appliquer à une autre, en général via un réglage fin (fine tuning).

L'apprentissage par transfert rend les modèles de fondation possibles, mais la montée en échelle les rend puissants. Ce scaling a exigé trois ingrédients :

- des améliorations du matériel informatique (les capacités du GPU et de la mémoire mobilisée ont augmenté d’un facteur 10 sur les 5 années écoulés) ;

- le développement de l'architecture de calcul qui exploite le parallélisme du matériel (« têtes multiples » d’attention qui parallélisent le calcul dans les couches de neurones) ;

- la disponibilité de beaucoup plus de données d'apprentissage. En 5 ans, il y a eu croissance exponentielle du nombre de paramètres intégrés dans le modèle, de quelques millions à quelques centaines de milliards (voir cet article sur le MT-NLG qui détient le record à date)...

La disponibilité des données a été considérablement élargie du fait de la capacité à se passer de jeux importants déjà annotés (spécifiés) par des humains. L'apprentissage par transfert à partir des ensembles de données annotés est une pratique courante depuis au moins une décennie, par exemple pour la classification des images dans la communauté de la vision par ordinateur. Des humains donnent quelques dizaines de milliers d’exemples de bon classement, la machine apprend sur ce jeu. Cependant, le coût non négligeable de l'annotation imposait une limite pratique aux avantages de ce pré-entraînement. L’auto-supervision a conduit à une forte accélération de l’apprentissage.

Apprentissage, auto-supervisé

Dans l'apprentissage auto-supervisé, la tâche de pré-entraînement est automatiquement dérivée de données non annotées. Par exemple, la tâche de modélisation du langage par masquage, utilisée pour former le BERT (Devlin et al. 2019), consiste à prédire un mot manquant dans une phrase compte tenu du contexte qui l'entoure. Ces tâches auto-supervisées sont plus évolutives, ne dépendent que de données non étiquetées et obligent les fonctions de décision du modèle à apprendre la structure de phrases dans des contextes très variés. Tous les modèles de fondation sont conçus ainsi : BERT (Devlin et al. 2019), GPT-2 (Radford et al. 2019), RoBERTa (Liu et al. 2019), T5 (Raffel et al. 2019), BART (Lewis et al. 2020).

L’apprentissage par mot masqué est ce qui permet au modèle d’intégrer le contexte du mot dans le très grand nombre d’exemples de textes qui lui sont donnés (milliards à centaines de milliards de tokens, le tokens étant généralement un mot). Par exemple un Transformer sait remplir les phrases « l’avion ------ dans deux heures » et « l’affiche se ------ du mur » ; du même coup, le Transformer apprend la polysémie du verbe décoller selon ses contextes d’énonciation, non par une compréhension au sens humain, mais par choix probabiliste du mot le plus cohérent dans une phrase.

Après 2019, l'apprentissage auto-supervisé avec des modèles linguistiques est devenu un substrat pour toutes les approches NLP, car l'utilisation des architectures BERT et GPT (modèles à encoder, decoder, encoder-decoder) est devenue la norme.

Le traitement automatique du langage fait sa révolution

Le domaine du traitement automatique du langage s'est historiquement concentré sur la création et la résolution de tâches linguistiques difficiles :

- classification pour une phrase ou un document entier (par exemple, la classification des sentiments, comme prédire la polarité positive ou négative d’une critique, d’un tweet, d’un commentaire),

- tâches d'étiquetage de séquence de mots dans une phrase ou un document (par exemple, prédire si chaque mot est un verbe ou un nom, s’ils font référence à une personne ou à une organisation),

- classification de la relation étendue et des dépendances grammaticales (par exemple, savoir si un nom et un verbe sont liés par une relation "sujet-verbe"),

- génération de texte conditionnée par une entrée (par exemple, produire une traduction ou un résumé d'un texte, répondre dans une conversation).

Dans le passé, ces tâches NLP avaient des communautés de recherche distinctes qui développaient des architectures spécifiques, chacune effectuant une sous-tâche linguistique ad hoc.

L'approche désormais dominante pour effectuer chaque tâche consiste plutôt à utiliser un modèle de fondation unique puis à l'adapter légèrement en utilisant des quantités relativement faibles de données annotées spécifiques à chaque tâche (classification des sentiments, étiquetage des entités nommées, traduction, résumé) pour créer un modèle adapté. Le résultat a été au rendez-vous. Exemple : le meilleur système pour répondre aux questions scientifiques ouvertes en 2018, avant les modèles de fondation, pouvait obtenir 73,1 % à l'examen (NY Regents). Un an plus tard en 2019, un modèle de fondation adapté obtenait un score de 91,6 %.

Débats sur l’avenir de l’IA Les chercheurs de l'université Stanford soulignent divers points d'attention et de débat sur l'avenir des modèles de fondation.

Concentration sur quelques acteurs. Les modèles IA de langage ont été développés par quelques acteurs mondiaux, soit des big tech (Google, Facebook, Microsoft, Huawei) soit des start-up (OpenAI, AI21), mais en raison du coût initial d'entraînement, le club est assez fermé. Le secteur public académique en particulier n’a pas encore développé ses propres modèles (voir en ce sens l’initiative BigScience).

Motivation commerciale vs démocratique. La motivation commerciale à l’origine du développement de l’IA peut conduire les entreprises à ignorer les externalités sociales comme le remplacement technologique de la main-d'œuvre, la santé d'un écosystème informationnel nécessaire à la démocratie, le coût environnemental des ressources informatiques, la vente de technologies à des régimes non démocratiques. Une entreprise est peu incitée à créer un écosystème ouvert et décentralisé pour développer des modèles de fondation avec une large participation.

Accessibilité et reproductibilité. Dans un premier temps, les modèles et les bibliothèques applicatives (comme le calcul tensoriel TensorFlow) ont été publiés en ligne et mis à la disposition de tous les acteurs, ce qui a contribué à l’accélération des progrès et à la diffusion des modèles. Mais ce mouvement n’a pas été constant, par exemple GPT3 est resté privé. De plus, la phase d’entraînement du modèle, qui est la plus critique pour l’analyse de la communauté des chercheurs IA, n’est que rarement publiée en détail. Un autre problème, plus fondamental, tient au fait qu’il n’est pas possible de reproduire les fonctions de décision du modèle. Celui-ci traite dans ses couches de neurones un espace à très haute dimension (des millions de paramètres) sans que cette « boîte noire » permette à date de repérer clairement ce qui lui fait décider d’un choix de classement ou de génération de texte en sortie. La science est plutôt habituée au principe de reproductibilité des calculs et des résultats, mais les modèles de fondation déjouent cela. Une même requête sur un prompteur de modèle decoder de type GPT peut donner des résultats variables quand elle est répétée, en raison du caractère non-déterministe du modèle.

Homogénéisation sans précédent. Presque tous les modèles NLP de pointe sont désormais adaptés à partir d’un modèle de fondation. En outre, la modélisation de séquences basées sur Transformer est maintenant appliquée au-delà du texte (images, parole, architectures 3D protéiques, composés chimiques, modèles de médicaments etc.). Cette homogénéisation produit des effets de levier : toute amélioration des modèles de fondation peut entraîner des avantages immédiats dans l'ensemble de la communauté du traitement automatique du langage. Mais elle est aussi un handicap : tous les systèmes d'IA pourraient hériter des mêmes biais problématiques de quelques modèles de base. Ainsi, les corpus de textes que le modèle de fondation ingurgite dans sa phase d’apprentissage des structures de la langue peuvent avoir des biais de composition (par exemple trop de langage universitaire et média, pas assez de langage populaire), des biais d’incomplétude (par exemple manque d’exemples dans certains domaines spécialisés ou de sociolectes propres à des communautés) ou encore des biais d’idéologie (par exemple sexisme, racisme, distorsion de faits par des opinions).

L’équipe Sensefab, qui développe la solution Youmean, partage ces constats faits par les chercheurs de Stanford. Comme beaucoup, nous utilisons des modèles Transformers pour certaines tâches NLP de la solution, mais notre réflexion nous oriente sur la capacité des utilisateurs à maîtriser et contrôler les résultats. Ce sera assurément un enjeu pour une IA responsable au cours de la décennie.

Référence : Rishi Bommasani et al (2021), On the Opportunities and Risks of Foundation Models